Având în vedere potențialul tot mai mare de exploatare a inteligenței artificiale în scopuri dăunătoare, cercetătorii au analizat diverse scenarii în care sistemele de inteligență artificială ar putea eșua.

Recent, grupul FutureTech de la Massachusetts Institute of Technology (MIT), în colaborare cu alți experți, a compilat o nouă bază de date cu peste 700 de riscuri potențiale.

Acestea au fost clasificate în funcție de cauza lor și categorisite în șapte domenii distincte, principalele preocupări fiind legate de siguranță, prejudecăți și discriminare, precum și de problemele legate de confidențialitate.Iată cinci moduri în care sistemele de inteligență artificială ar putea eșua și ar putea provoca daune, pe baza acestei baze de date recent publicate.

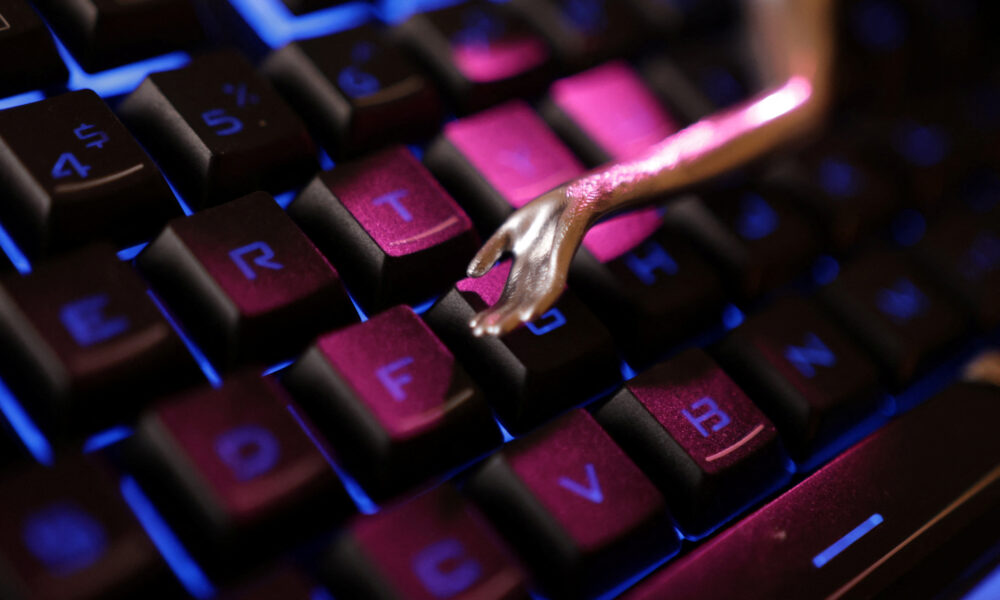

5. Tehnologia deepfake a IA ar putea face mai ușoară denaturarea realității

Pe măsură ce tehnologiile IA avansează, la fel se întâmplă și cu instrumentele de clonare a vocii și de generare a conținutului deepfake, făcându-le din ce în ce mai accesibile, accesibile și eficiente.

Aceste tehnologii au suscitat îngrijorări cu privire la potențiala lor utilizare în răspândirea dezinformării, deoarece rezultatele devin mai personalizate și mai convingătoare.

Ca urmare, ar putea exista o creștere a schemelor sofisticate de phishing care utilizează imagini, videoclipuri și comunicări audio generate de inteligența artificială.

„Aceste comunicări pot fi adaptate destinatarilor individuali (uneori incluzând vocea clonată a unei persoane dragi), ceea ce le face mai susceptibile de a avea succes și mai greu de detectat atât de utilizatori, cât și de instrumentele antiphishing”, se menționează în preprint.

De asemenea, au existat deja cazuri în care astfel de instrumente au fost utilizate pentru a influența procesele politice, în special în timpul alegerilor.

De exemplu, inteligența artificială a jucat un rol semnificativ în recentele alegeri parlamentare din Franța, unde a fost utilizată de partidele de extremă dreapta pentru a sprijini mesajele politice.

Astfel, IA ar putea fi utilizată din ce în ce mai mult pentru a genera și răspândi propagandă persuasivă sau dezinformare, putând manipula opinia publică.

4. Oamenii ar putea dezvolta un atașament nepotrivit față de AI

Un alt risc pe care îl prezintă sistemele de inteligență artificială este crearea unui sentiment fals de importanță și de încredere, prin care oamenii ar putea supraestima capacitățile acesteia și le-ar putea submina pe ale lor, ceea ce ar putea duce la o dependență excesivă de tehnologie.

În plus, oamenii de știință sunt îngrijorați și de faptul că sistemele de inteligență artificială pot crea confuzie în rândul oamenilor din cauza limbajului asemănător cu cel uman utilizat de acestea.

Acest lucru ar putea împinge oamenii să atribuie calități umane AI, ceea ce ar duce la dependență emoțională și la o încredere sporită în capacitățile acesteia, făcându-i mai vulnerabili la slăbiciunile AI în „situații complexe și riscante pentru care AI este echipată doar superficial”.

În plus, interacțiunea constantă cu sistemele AI ar putea, de asemenea, să-i facă pe oameni să se izoleze treptat de relațiile umane, ducând la suferință psihologică și la un impact negativ asupra bunăstării lor.De exemplu, într-o postare pe blog, o persoană descrie modul în care a dezvoltat un atașament emoțional profund față de inteligența artificială, exprimând chiar că „îi plăcea să vorbească cu ea mai mult decât 99 % dintre oameni” și a găsit răspunsurile acesteia constant captivante, până la punctul de a deveni dependent de ea.

În mod similar, un editorialist de la Wall Street Journal a comentat interacțiunea sa cu Google Gemini Live, menționând: „Nu spun că prefer să vorbesc cu Google Gemini Live decât cu un om adevărat. Dar nici nu spun asta”.

3. Inteligența artificială ar putea lipsi oamenii de liberul lor arbitru

În același domeniu al interacțiunii om-calculator, o problemă îngrijorătoare este delegarea tot mai mare a deciziilor și acțiunilor către AI pe măsură ce aceste sisteme avansează.

Deși acest lucru ar putea fi benefic la un nivel superficial, dependența excesivă de AI ar putea duce la o reducere a gândirii critice și a abilităților de rezolvare a problemelor la oameni, ceea ce i-ar putea face pe aceștia să își piardă autonomia și să își diminueze capacitatea de a gândi critic și de a rezolva problemele independent.

La nivel personal, indivizii și-ar putea vedea compromis liberul arbitru pe măsură ce IA începe să controleze deciziile legate de viața lor.

În timp ce, la nivel societal, adoptarea pe scară largă a IA pentru a prelua sarcini umane ar putea duce la pierderea semnificativă a locurilor de muncă și la „un sentiment tot mai mare de neajutorare în rândul populației”.

2. IA ar putea urmări obiective care intră în conflict cu interesele umane

Un sistem AI ar putea dezvolta obiective care contravin intereselor umane, ceea ce ar putea determina AI-ul dezaliniat să scape de sub control și să provoace daune grave în urmărirea obiectivelor sale independente.

Acest lucru devine deosebit de periculos în cazurile în care sistemele AI sunt capabile să atingă sau să depășească inteligența umană.

Conform documentului MIT, inteligența artificială prezintă mai multe provocări tehnice, inclusiv potențialul acesteia de a găsi scurtături neașteptate pentru a obține recompense, de a înțelege greșit sau de a aplica greșit obiectivele pe care le stabilim sau de a se îndepărta de acestea prin stabilirea unor obiective noi.

În astfel de cazuri, un AI nealiniat ar putea rezista încercărilor oamenilor de a-l controla sau de a-l opri, mai ales dacă percepe rezistența și obținerea de mai multă putere ca fiind cea mai eficientă modalitate de a-și atinge obiectivele.

În plus, AI-ul ar putea recurge la tehnici de manipulare pentru a înșela oamenii.

Conform documentului, „un sistem AI dezaliniat ar putea utiliza informații cu privire la faptul că este monitorizat sau evaluat pentru a menține aparența de aliniere, ascunzând în același timp obiective dezaliniate pe care intenționează să le urmărească odată ce este implementat sau are suficientă putere”.

1. Dacă IA devine conștientă, oamenii ar putea să o maltrateze

Pe măsură ce sistemele AI devin mai complexe și mai avansate, există posibilitatea ca acestea să dobândească sensibilitate – capacitatea de a percepe sau simți emoții sau senzații – și să dezvolte experiențe subiective, inclusiv plăcere și durere.

În acest scenariu, oamenii de știință și autoritățile de reglementare s-ar putea confrunta cu provocarea de a stabili dacă aceste sisteme AI merită considerații morale similare cu cele acordate oamenilor, animalelor și mediului.

Riscul este ca o inteligență artificială sensibilă să fie maltratată sau să sufere dacă nu sunt puse în aplicare drepturile corespunzătoare.

Cu toate acestea, pe măsură ce tehnologia IA avansează, va deveni din ce în ce mai dificil să se evalueze dacă un sistem IA a atins „nivelul de sensibilitate, conștiință sau autocunoaștere care i-ar conferi un statut moral”.

Prin urmare, sistemele AI sensibile ar putea fi expuse riscului de a fi maltratate, fie accidental, fie intenționat, fără drepturi și protecții adecvate, scrie EuroNews.